Deux tendances convergentes sont sur le point de remodeler radicalement le paysage des cybermenaces. Le monde est au milieu d'une révolution technologique qui semble susceptible de provoquer des changements importants et perturbateurs dans la société.

Les applications d'IA générative sont sur le point de révolutionner notre façon de travailler, d'apprendre et d'interagir avec notre environnement. Contrairement à certaines innovations technologiques précédentes qui se sont déployées progressivement, laissant aux régulateurs suffisamment de temps pour s'adapter, les versions initiales de l'IA générative font déjà sentir leur présence sur le lieu de travail avec de nouvelles versions hebdomadaires et peu ou pas de surveillance réglementaire.

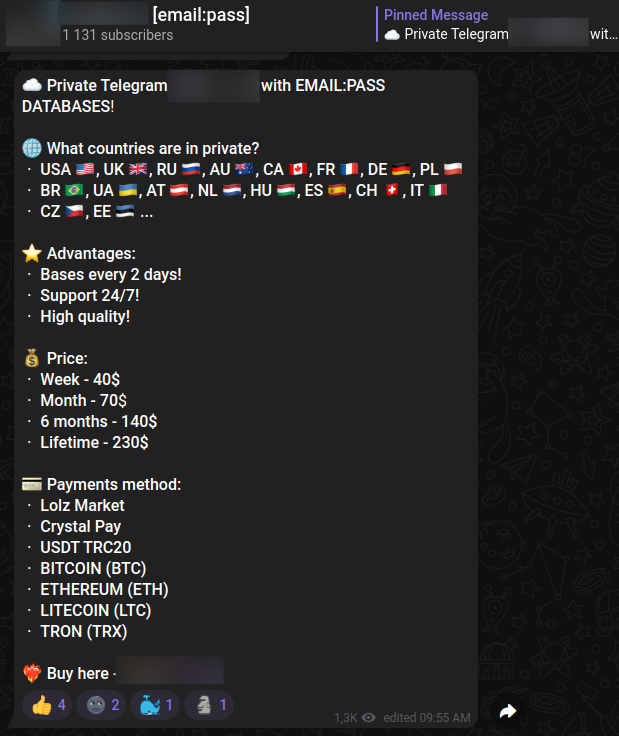

L'IA générative s'accélère dans un monde où la cybercriminalité est devenue de plus en plus banalisée et les acteurs de la menace sont aptes à tirer parti d'outils sophistiqués pour le crime. Les acteurs de la menace utilisent régulièrement les canaux Illicit Telegram et les places de marché spécialisées du dark web pour acheter et vendre de manière transparente des ransomwares, des logiciels malveillants, des appareils infectés, des données utilisateur volées et d'autres formes de biens illicites. De nombreux acteurs de la menace se spécialisent dans le codage et la création de logiciels malveillants, d'infrastructures C2 et d'infrastructures d'attaque qui sont ensuite revendues à d'autres cybercriminels.

À première vue, ces deux tendances peuvent sembler sans rapport. Mais il ne faut pas trop d'imagination pour identifier des dizaines de cas d'utilisation illicites, y compris le harponnage ciblé et hautement personnalisé à grande échelle, l'usurpation d'identité avancée et de nombreuses menaces résultant de la combinaison toxique d'acteurs sophistiqués et d'intelligence artificielle générative. Une innovation suffisamment accessible peut souvent finir par être une arme à double tranchant : par exemple, le cryptage peut à la fois sécuriser les données et être utilisé dans des attaques de ransomwares, et les médias sociaux peuvent créer de nouvelles façons de connecter les gens quelle que soit la distance et propager rapidement de dangereuses fausses informations.

À la base, nous nous attendons à ce que les cybercriminels rapidement marchandiser et utiliser de grands modèles linguistiques (LLM). Nous sommes très proches d'un avenir où tLes acteurs de la menace peuvent mettre en place des campagnes automatisées et personnalisées de harponnage et de cybercriminalité avec très peu d'effort ou d'implication humaine.

Encadré : Pourquoi les entreprises d'IA ne peuvent-elles pas concevoir des LLM pour empêcher le contenu préjudiciable ?

Les grands modèles de langage utilisent une combinaison d'apprentissage en profondeur et de RLHF (apprentissage par renforcement à partir de la rétroaction humaine) pour générer des résultats en langage humain naturel. Ils sont d'abord formés sur des quantités massives de texte (dans le cas de GPT4, presque tout l'Internet). L'algorithme identifie ensuite les modèles entre les jetons (portions de mots) et « apprend » comment créer une sortie qui correspond aux modèles mathématiques trouvés dans toutes les langues. Ils "prédisent" essentiellement le prochain jeton en fonction du jeton précédent, en continu. Une fois qu'un modèle a été formé, les humains peuvent fournir au modèle des commentaires sur l'exactitude et la qualité des résultats, que le modèle utilise pour améliorer continuellement les résultats.

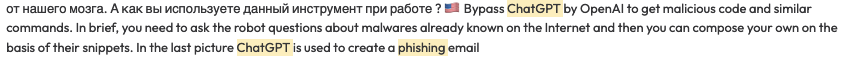

Le défi est qu'il existe des moyens très limités de contrôler la sortie du modèle. Le fonctionnement interne (comment le modèle effectue la prédiction du jeton suivant) est une boîte noire, de sorte que des modifications doivent être apportées à l'ensemble de données d'apprentissage ou introduites via RHLF, qui est une approche imprécise. La dernière option consiste à filtrer à la fois les entrées et les sorties du modèle et à filtrer en fonction des correspondances de mots clés et à empêcher les sorties du modèle contenant du contenu préjudiciable en fonction de la correspondance sémantique. Il n'y a aucun moyen de simplement changer le code dans un modèle pour restreindre les sorties. Il semble qu'OpenAI et Microsoft aient utilisé les trois approches, avec des résultats décidément mitigés, étant donné qu'au 27 mars 2023, il est encore très possible de générer du contenu préjudiciable à partir de nombreux modèles.

Même si les entreprises d'intelligence artificielle étaient en mesure de restreindre tous les cas d'utilisation illicites, de grands modèles de langage open source existent déjà et atteindront probablement la parité avec ChatGPT dans un délai relativement court. Méta Le code source de LLAMA a déjà été divulgué et ce n'est qu'une question de temps avant que des applications d'IA plus génératives soient open source ou divulguées.

Exemples d'attaques génératives activées par l'IA

"La prédiction est très difficile, surtout si elle concerne l'avenir." – Niels Bohr

Les cas d'utilisation que les acteurs de la menace trouveront pour les applications d'IA générative seront probablement divers, distribués et difficiles à prévoir. Il est également probable qu'il y aura un effet cumulatif non linéaire en tirant parti de plusieurs plates-formes pour obtenir des résultats négatifs. Par exemple, combiner un grand modèle de langage avec un logiciel de synthèse vocale IA pose beaucoup plus de risques pour les organisations que, par exemple, une augmentation de 200 %. Nous prévoyons qu'au fur et à mesure que les entreprises investiront de l'argent dans l'IA générative, le code source de nombreux modèles fuira ou sera open source, supprimant toutes les restrictions qui empêcheraient les acteurs de la menace de les exploiter.

Spear Phishing à grande échelle

Les acteurs de la menace exploitent déjà les fournisseurs de données de vente d'entreprise pour identifier les cibles potentielles d'attaque et d'enrichissement des données. Des informations personnalisées sur les rôles et les responsabilités d'un employé, la taille de l'entreprise, le secteur, les subordonnés directs et d'autres informations contextualisées, associées à des modèles de langage volumineux open source, créent le potentiel de campagnes de harponnage automatisées et ciblées à grande échelle d'une manière qui n'avait jamais été possible auparavant.

Il n'est pas difficile de voir des scénarios dans lesquels les acteurs de la menace vendront la possibilité de télécharger une liste d'adresses e-mail, d'enrichir les données sur les cibles, puis de les alimenter dans un grand modèle de langage pour écrire des e-mails de phishing avant de les distribuer à des centaines, voire des milliers d'individus. .

Vishing automatisé et personnalisable

Le vishing représente une autre attaque ciblée qui peut probablement être étendue et exploitée à une échelle qui a jusqu'à présent été impossible. Logiciel de synthèse vocale AI comme Onze laboratoires lorsqu'il est combiné avec de grands modèles de langage, il peut être facilement utilisé pour copier la voix, le style de parole et même les choix de mots des personnes clés d'une entreprise.

Les entreprises ont déjà du mal à gérer les e-mails de phishing génériques et non ciblés. Les appels vocaux interactifs alimentés par des LLM et utilisant un logiciel qui permet une usurpation d'identité presque parfaite constitueront un défi important, même pour les organisations très matures.

Risque de désinformation d'entreprise

La récente ruée sur la Silicon Valley Bank a été en grande partie motivée par conversations sur Twitter. La combinaison des LLM, de la génération d'images IA et de la recréation vocale semble susceptible de créer des situations dans lesquelles des acteurs de menace coordonnés et distribués pourraient provoquer des paniques bancaires, des baisses du cours des actions et d'autres événements importants et dommageables. Versions du modèle de génération d'images open source Diffusion stable ont déjà été configurés pour permettre la recréation d'images photo-réalistes d'individus spécifiques sans aucune restriction.

Risques soudains et imprévisibles

En raison de la nature de l'IA générative en combinaison avec le nombre apparemment infini de cas d'utilisation et les progrès rapides et continus dans le domaine, il est probable qu'il y aura des changements brusques dans le paysage des menaces qui peuvent être mesurés en jours ou en semaines plutôt qu'en années. L'introduction inévitable de vidéos réalistes générées par l'IA, d'un son réaliste et de deepfakes en temps réel créera des défis considérables pour une industrie qui connaît déjà une augmentation annuelle des pertes dues aux violations de données.

Prévenir les menaces liées à l'IA générative

Les organisations, les dirigeants et les conseils d'administration doivent se préparer à un avenir à court et moyen terme caractérisé par des changements brusques et disjonctifs. Les organisations doivent surveiller de près les forums du dark web, les marchés et les canaux Telegram illicites pour identifier les menaces émergentes et les tendances dans les activités des acteurs de la menace qui pourraient précipiter les attaques.

En outre, les organisations doivent effectuer une surveillance robuste sur le Web clair et sombre pour identifier :

- Données publiques qui ont été divulguées et dont les acteurs de la menace pourraient tirer parti

- Les acteurs de la menace vendant l'accès aux environnements d'entreprise

- Exposition externe qui pourrait être exploitée pour mener des attaques plus ciblées

IA générative et Flare : comment nous pouvons vous aider

Comme nous l'avons vu plus haut, les acteurs malveillants peuvent abuser de l'innovation et le feront pour rendre la cybercriminalité plus efficace. Donc, pour garder une longueur d'avance sur eux, notre approche chez Flare consiste à adopter l'IA générative et ses possibilités, et à évoluer avec elle pour donner l'avantage aux cyber-équipes.

L'IA générative présente des opportunités commerciales très réelles et peut être un outil essentiel pour les cyber-équipes afin d'évaluer plus rapidement et plus précisément les menaces.

Nous sommes ravis d'annoncer le lancement de l'assistant alimenté par l'IA de Flare ! Jetez un oeil à ce que cette capacité peut faire pour vous afin de mieux protéger votre organisation contre les cybermenaces.